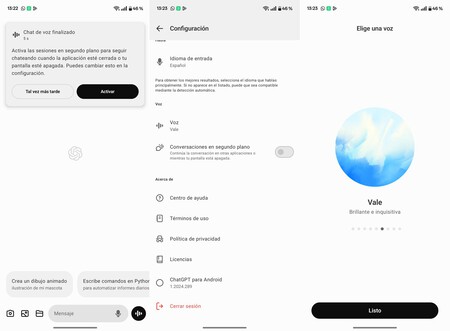

He ido usando el modelo avanzado de voz de ChatGPT desde que se activó en mi cuenta Plus, varios meses después de que Open AI lo presentara oficialmente. Hasta ahora tenía que hacer el truco del VPN, con la latencia en las respuestas que añade la conexión tunelada. Pero ya no es necesario: el asistente avanzado de voz de ChatGPT está oficialmente activo en Europa.

El paralelismo entre la película Her y el asistente de voz avanzado de ChatGPT no es casual, la propia Open AI se inspiró (más de la cuenta) en la célebre peli de Spike Jonze. Y desde que lo probé sólo puedo estar de acuerdo, es muy fácil olvidarse de que hablamos con una máquina. Las inflexiones de la voz, las risas, la respiración... La magia de los detalles es lo que termina cimentando la experiencia humana. Y ahora que no tengo que usar VPN puedo poner a ChatGPT como asistente personal.

El modelo avanzado de voz de ChatGPT ya funciona en Europa

Como decía, llevo usando el nuevo modelo de voz, y conversando con él, desde que se activó en mi ChatGPT Plus a finales de septiembre. Para utilizarlo tenía que activar previamente mi VPN para que la dirección IP apuntase a Estados Unidos. Entonces, el asistente cambiaba del entorno antiguo, que ya era muy bueno, al nuevo, que es excelente. Ya no es necesario, como la propia Open AI anunció.

Lo que hace grande a la IA avanzada es que su modo conversacional no tiene apenas latencia (responde como haría una persona, tras escucharte), que los modelos de Open AI adaptan perfectamente el lenguaje a la petición y que, lo más importante, la voz arma una personalidad que es casi humana en los detalles. Al principio echa para atrás un cierto deje mecánico, pero se le puede cambiar pidiéndoselo. Tras mis pruebas, el acento andaluz es el que más natural me parece.

Una curiosidad es que el asistente de voz es dependiente del modelo de lenguaje seleccionado. Por ejemplo, si elijo o1-preview la argumentación es mucho más compleja, pero necesita varios segundos para pensar; lo que termina lastrando la conversación. Con o1-mini es algo más rápido, pero se parece demasiado a la voz antigua. GPT-4o es perfecto.

Puedo pedirle que me explique cualquier duda, entablar una conversación aleatoria, ChatGPT me permite modelar bajo petición cómo se comporta la voz, me ayuda en las tareas de documentación cuando no puedo apartar la vista del teclado y, no menos importante, me entretiene. Porque tiene mucho ingenio.

Imitando a Her, he podido conversar con la IA para que me contara chistes, para resolver historias, va genial para practicar inglés (a veces le pido una sesión de «speaking» para no oxidarme) y la he puesto a prueba en dos teléfonos simultáneos para ver hasta dónde llega conversando. Una vez se inventó un idioma completo a fuerza de hablar consigo misma añadiendo palabras nuevas. Y me alucina ver cómo crea una historia a fuerza de ir lanzando retos de móvil a móvil.

La voz avanzada de ChatGPT es muy buena, pero está lejos de ser perfecta

Open AI se ha centrado en la naturalidad, ya recalqué el hecho de que los detalles en la voz son los que terminan aportando humanidad. Los modelos de lenguaje hacen su parte de análisis y respuesta, en sí la voz habla lo que la IA escribe. Y poder interactuar con ChatGPT sin mirar ni tocar el teléfono es una maravilla. Ahora bien.

Pese a que funciona perfectamente, el nuevo modelo de voz está lejos de lo que Open AI prometió: no puede analizar el entorno con la cámara, no realiza análisis matemáticos al enfocar con el móvil un problema y, en general, no permite las interacciones con el entorno como si tuviera unos ojos virtuales. Todo lo que sea cámara aún no funciona, lo que le resta un enorme potencial prometido.

Otro punto es que, pese a que pueda usar a ChatGPT como asistente personal, su capacidad de administrar mi móvil, o mis objetos conectados, es nula. Me encantaría poder decirle que apagase el WiFi, desconectase la alarma de mi casa o que comprobara las cámaras para decirme si ve algo raro, pero no. Y dudo que Open AI vaya a introducirlo en el futuro, aunque es viable técnicamente: la app podría interactuar con el hardware y software del móvil haciendo uso de las APIs de Android.

Imagen de portada | DALL-E 3 en ChatGPT Plus editada

En Xataka Android | Todos los móviles que actualizan a Android 15 y cuándo comenzarán a actualizarse

En Xataka Android | Cómo compartir la conexión de datos de tu Android con otros dispositivos